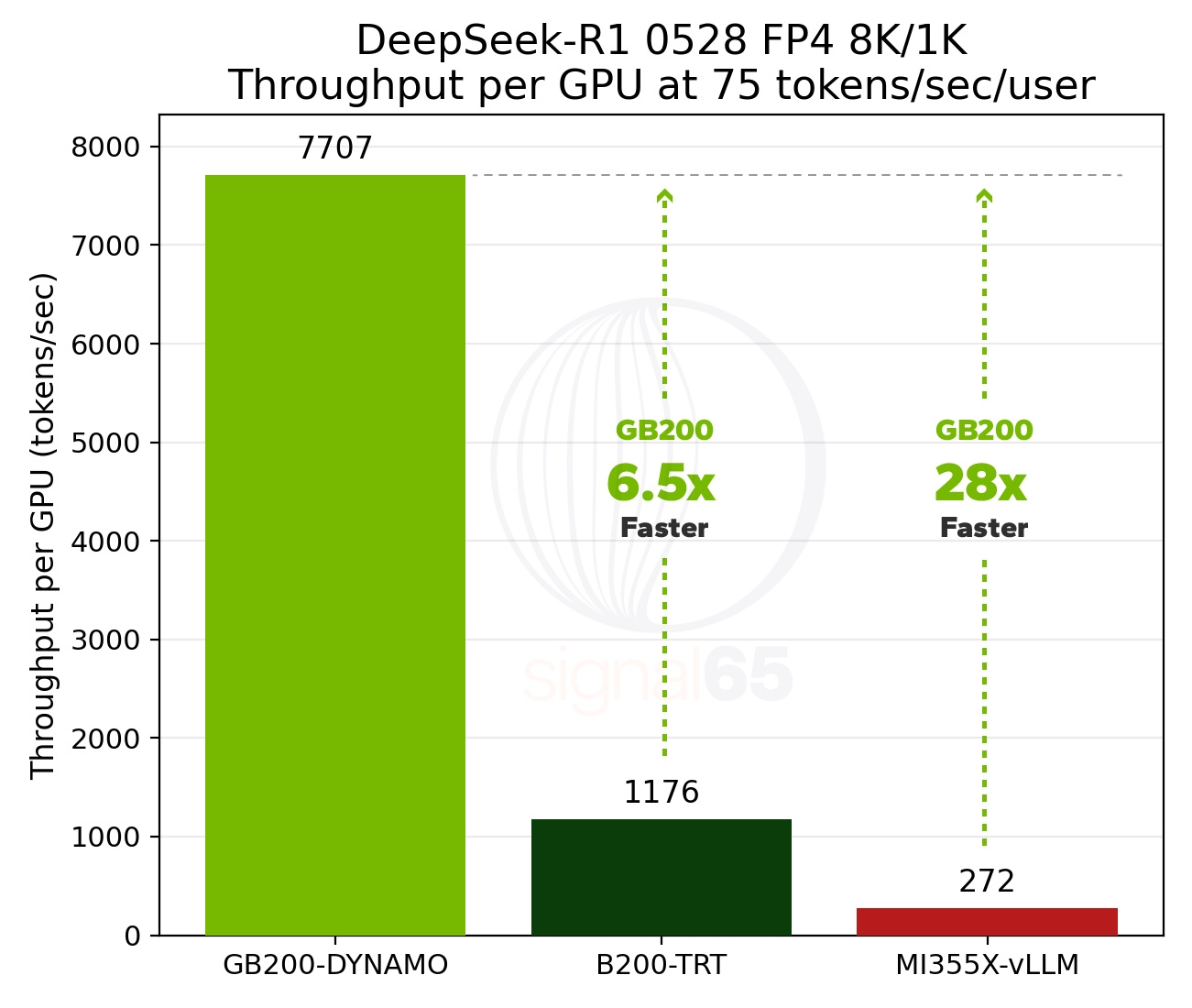

Yapay zeka dünyasında Mixture of Experts (MoE) mimarisine geçiş hız kazanırken bu alandaki donanım rekabeti de giderek sertleşiyor. Signal65 tarafından yayımlanan ve SemiAnalysis’in InferenceMAX ölçümlerine dayanan yeni bir analiz, Nvidia’nın Blackwell tabanlı GB200 NVL72 raf sistemlerinin AMD’nin Instinct MI355X çözümlerine kıyasla dikkat çekici bir üstünlük sağladığını ortaya koydu. Test sonuçlarına göre Nvidia, MoE iş yüklerinde GPU başına 28 kata varan performans artışı sunuyor.

Yapay zeka dünyasında Mixture of Experts (MoE) mimarisine geçiş hız kazanırken bu alandaki donanım rekabeti de giderek sertleşiyor. Signal65 tarafından yayımlanan ve SemiAnalysis’in InferenceMAX ölçümlerine dayanan yeni bir analiz, Nvidia’nın Blackwell tabanlı GB200 NVL72 raf sistemlerinin AMD’nin Instinct MI355X çözümlerine kıyasla dikkat çekici bir üstünlük sağladığını ortaya koydu. Test sonuçlarına göre Nvidia, MoE iş yüklerinde GPU başına 28 kata varan performans artışı sunuyor.

Yapay zeka modelleri, kaynak kullanımını daha verimli hale getirdiği için hızla MoE odaklı bir yapıya evriliyor. Bu yaklaşımda model, “uzman” olarak adlandırılan ayrı alt ağlara bölünüyor ve her sorguda yalnızca ilgili uzmanlar çalıştırılıyor. Ancak bu yapıda ölçek büyüdükçe düğümler arası yoğun veri aktarımı, gecikme ve bant genişliği baskısı gibi sorunlar da artıyor. Bu nedenle Amazon Web Services (AWS), Google Cloud, Microsoft Azure ve Oracle Cloud gibi ‘hiperölçekleyiciler” yalnızca ham performansa değil, performans başına maliyet dengesine de odaklanıyor. Signal65’in değerlendirmesine göre, mevcut tabloda bu dengeyi en iyi sağlayan çözüm Nvidia GB200 NVL72 olarak öne çıkıyor.

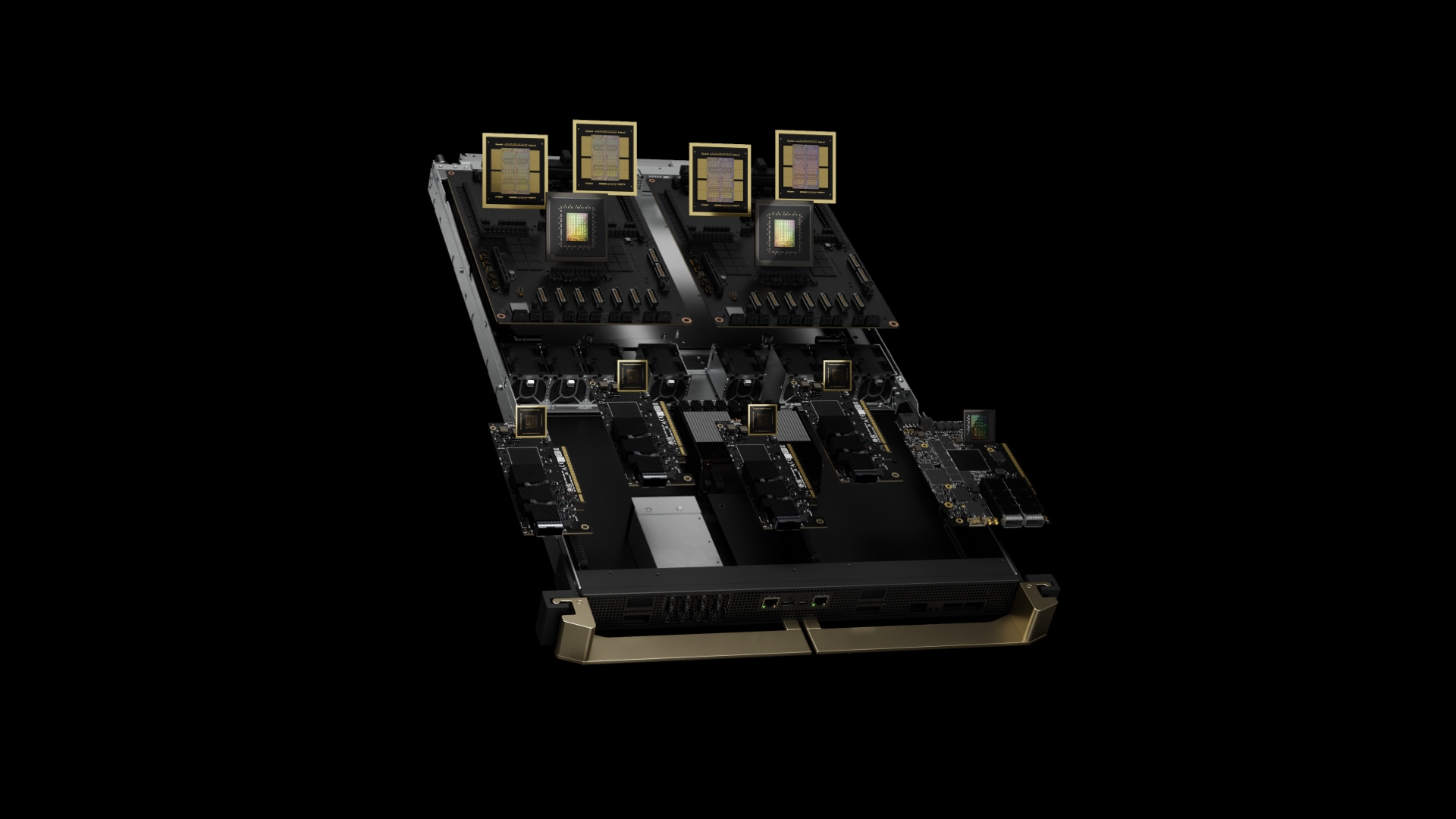

72 çip ve 30 TB paylaşımlı bellek

Analizin dikkat çeken noktalarından biri, Nvidia’nın performans farkını nasıl yarattığına dair teknik detaylar. Şirket, MoE ölçekleme darboğazlarını aşmak için “Extreme Co-Design” adını verdiği bir yaklaşım benimsiyor. Bu strateji kapsamında 72 adet GB200 çip, 30 TB yüksek hızlı paylaşımlı bellek ile tek bir raf sistemi içinde entegre şekilde çalışıyor. Bu mimarinin gecikmeleri ciddi şekilde azalttığı ifade ediliyor. Sonuç olarak InferenceMAX verilerine göre Nvidia’nın Blackwell tabanlı AI sunucuları, GPU başına saniyede 75 token işleyerek benzer küme yapılandırmasındaki AMD MI355X sistemlerini açık ara geride bırakıyor.

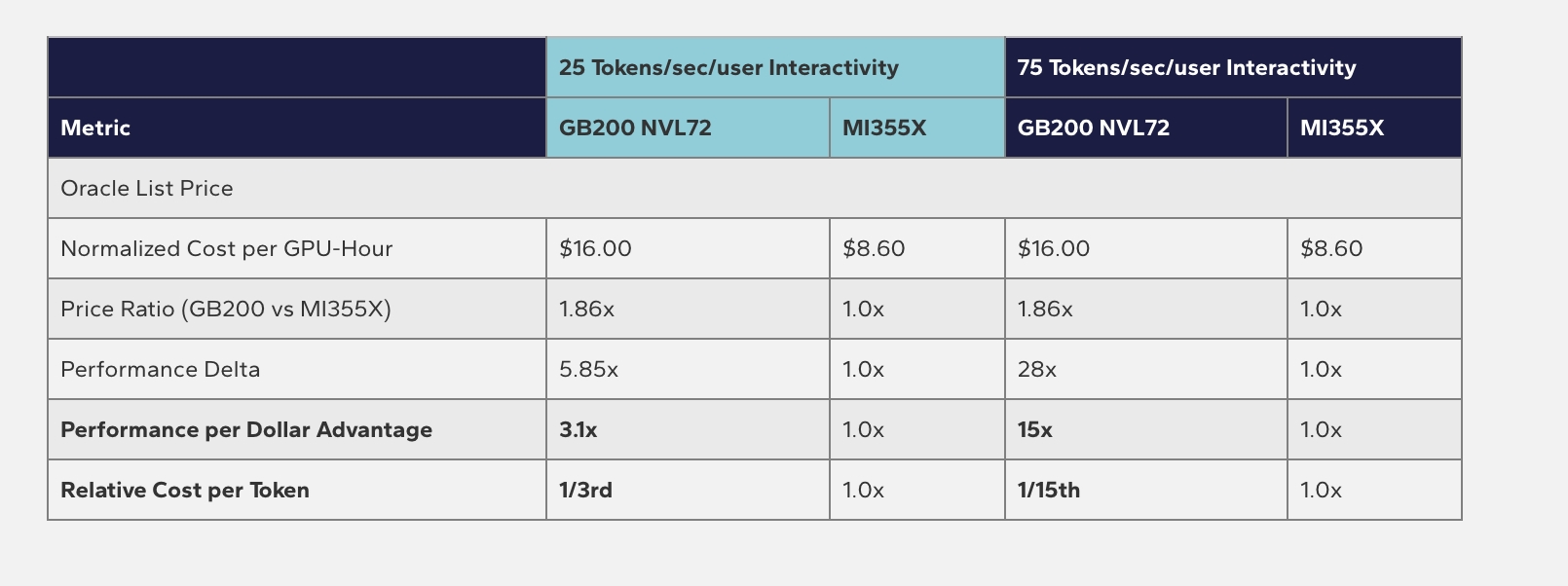

Analizin dikkat çeken noktalarından biri, Nvidia’nın performans farkını nasıl yarattığına dair teknik detaylar. Şirket, MoE ölçekleme darboğazlarını aşmak için “Extreme Co-Design” adını verdiği bir yaklaşım benimsiyor. Bu strateji kapsamında 72 adet GB200 çip, 30 TB yüksek hızlı paylaşımlı bellek ile tek bir raf sistemi içinde entegre şekilde çalışıyor. Bu mimarinin gecikmeleri ciddi şekilde azalttığı ifade ediliyor. Sonuç olarak InferenceMAX verilerine göre Nvidia’nın Blackwell tabanlı AI sunucuları, GPU başına saniyede 75 token işleyerek benzer küme yapılandırmasındaki AMD MI355X sistemlerini açık ara geride bırakıyor.  Yalnızca performans değil, toplam sahip olma maliyeti (TCO) tarafında da Nvidia’nın belirgin bir avantajı bulunuyor. Signal65, Oracle Cloud fiyatlandırmalarını referans alarak yaptığı hesaplamada, GB200 NVL72 raflarının token başına göreli maliyetinin 15’te 1 seviyesine kadar düştüğünü belirtiyor. Bu tablo, Nvidia’nın donanım yığınının neden bulut sağlayıcıları ve büyük ölçekli AI geliştiricileri tarafından bu kadar yaygın tercih edildiğini net biçimde ortaya koyuyor.

Yalnızca performans değil, toplam sahip olma maliyeti (TCO) tarafında da Nvidia’nın belirgin bir avantajı bulunuyor. Signal65, Oracle Cloud fiyatlandırmalarını referans alarak yaptığı hesaplamada, GB200 NVL72 raflarının token başına göreli maliyetinin 15’te 1 seviyesine kadar düştüğünü belirtiyor. Bu tablo, Nvidia’nın donanım yığınının neden bulut sağlayıcıları ve büyük ölçekli AI geliştiricileri tarafından bu kadar yaygın tercih edildiğini net biçimde ortaya koyuyor. Elbette bu veriler, AMD ile Nvidia arasındaki rekabetin tamamını temsil etmiyor. AMD’nin MI355X Instinct çözümleri, özellikle yüksek HBM3e bellek kapasitesi sayesinde yoğun ve sıkıştırılmış ortamlarda agresif bir alternatif olmaya devam ediyor. Ancak mevcut nesilde, MoE iş yükleri özelinde üstünlüğün Nvidia tarafında olduğu görülüyor. Önümüzdeki dönemde Helios ve Vera Rubin gibi yeni raf ölçekli çözümlerle rekabetin daha da kızışması bekleniyor.

Kaynak : https://www.donanimhaber.com/nvidia-gb200-nvl72-amd-ye-gore-buyuk-performans-farki-sagliyor–200403